AnythingLLM不是用来训练大模型的

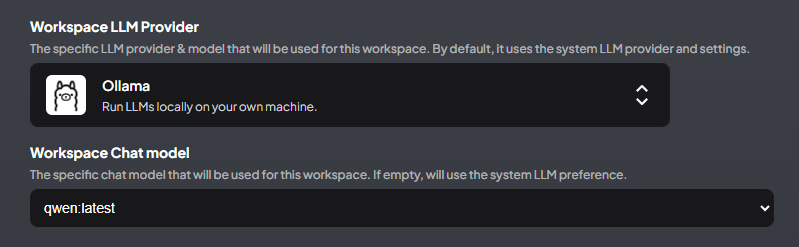

AnythingLLM不是用来训练大语音模型的,而是用来在大语言模型基础上建立自己的知识库的,对于这一点,好多人都容易混淆,Anything LLM 主要用于知识库管理和检索增强(RAG),而训练大语言模型是一个独立的、更底层的过程。

在 Anything LLM 中建立自己的知识库,和训练自己的大模型,是两个相关但不同的过程,它们的目标和方法有显著区别。

- 建立知识库 是一个轻量级、动态化的过程,适合快速增强 LLM 的能力。

- 训练大模型 是一个更复杂、资源密集的过程,适合需要高度定制化和独立性的场景。

两者可以结合使用:先通过知识库增强模型表现,再根据需要训练大模型,以实现最佳效果。

建立知识库和训练大模型的区别

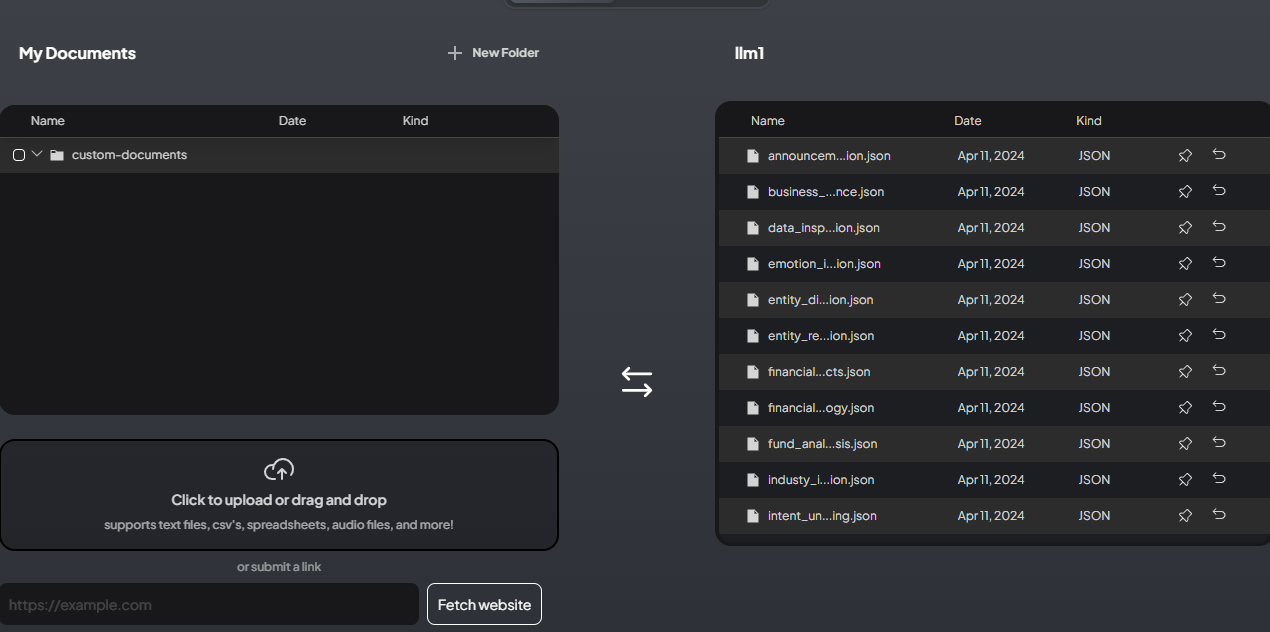

1. 在 Anything LLM 中建立知识库

- 目标:

- 将外部数据(如文档、网页、笔记等)导入 Anything LLM,形成一个结构化的知识库。

- 知识库用于增强 LLM(大语言模型)的上下文理解能力,使其能够基于这些数据生成更准确的回答。

- 过程:

- 数据导入:

- 将文档(如 PDF、Markdown、文本文件等)上传到 Anything LLM。

- Anything LLM 会解析这些文档,提取文本内容。

- 数据索引:

- Anything LLM 使用向量数据库(如 Pinecone、Weaviate 或本地向量存储)对文本进行索引。

- 索引的目的是将文本转换为向量表示,便于快速检索。

- 查询增强:

- 当用户提问时,Anything LLM 会从知识库中检索相关文档片段,并将其作为上下文输入到 LLM 中。

- LLM 基于检索到的上下文生成回答。

- 数据导入:

- 特点:

- 无需训练模型:知识库本身不涉及模型训练,而是通过检索增强(Retrieval-Augmented Generation, RAG)的方式提升模型的表现。

- 动态更新:知识库可以随时更新,添加新的文档或删除旧的内容。

- 依赖基础模型:知识库的效果依赖于底层 LLM 的能力(如 GPT-4、LLaMA 等)。

2. 训练自己的大模型

- 目标:

- 基于知识库数据,微调或训练一个全新的大语言模型,使其能够直接生成与知识库内容相关的回答。

- 训练后的模型可以独立运行,不依赖外部检索机制。

- 过程:

- 数据准备:

- 从知识库中提取结构化数据(如问答对、文档片段等)。

- 清洗和格式化数据,使其适合模型训练。

- 模型选择:

- 选择一个基础模型(如 GPT-3、LLaMA、Falcon 等)。

- 微调训练:

- 使用知识库数据对基础模型进行微调。

- 微调可以是全参数微调,也可以是高效微调(如 LoRA)。

- 评估与部署:

- 评估训练后模型的性能。

- 将模型部署到生产环境,替换或增强 Anything LLM 的默认模型。

- 数据准备:

- 特点:

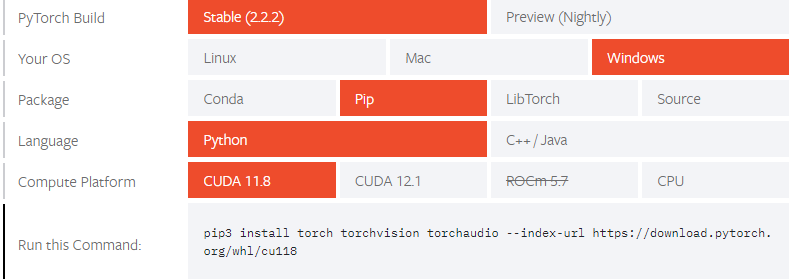

- 需要训练:涉及模型训练,需要大量计算资源(如 GPU/TPU)。

- 独立性:训练后的模型可以直接生成回答,无需依赖外部知识库检索。

- 静态性:模型一旦训练完成,其知识是固定的,除非重新训练或微调。

3. 两者的区别

| 方面 | 建立知识库 | 训练大模型 |

|---|---|---|

| 目标 | 增强 LLM 的上下文理解能力 | 创建一个独立的大模型 |

| 是否需要训练 | 不需要 | 需要 |

| 数据使用方式 | 通过检索增强(RAG)提供上下文 | 直接用于模型训练 |

| 动态更新 | 知识库可以随时更新 | 模型需要重新训练才能更新 |

| 计算资源需求 | 较低(主要是索引和检索) | 较高(需要 GPU/TPU 进行训练) |

| 依赖基础模型 | 是 | 是(但训练后可以独立运行) |

4. 两者的联系

- 数据来源:

- 两者都依赖于知识库数据。建立知识库是训练大模型的前提条件。

- 目标一致:

- 两者的最终目标都是提升模型在特定领域或任务上的表现。

- 互补性:

- 在 Anything LLM 中,可以先建立知识库,通过检索增强提升模型表现;如果效果不足,可以进一步训练大模型。

- 迭代优化:

- 知识库可以用于训练大模型,而训练后的大模型可以进一步优化知识库的检索效果。

5. 如何选择?

- 选择建立知识库:

- 如果你的目标是快速增强 LLM 的上下文理解能力,且不需要训练模型。

- 如果你的数据量较小,或者计算资源有限。

- 选择训练大模型:

- 如果你的目标是创建一个完全独立的、针对特定领域的大模型。

- 如果你有足够的计算资源和时间,且需要模型具备更高的自主性。

实训大语言模型

我将以一个具体的应用场景为例,详细说明如何从一个基础大模型开始训练自己的大语言模型,并提供关键步骤的 Python 代码示例。

应用场景

假设我们有一个医疗领域的知识库(如医学问答对、临床指南等),目标是训练一个专门用于医疗问答的大语言模型。

训练步骤

1. 准备数据

- 数据来源:从公开的医疗问答数据集(如 MedQA、PubMedQA)或自己的知识库中提取问答对。

- 数据格式:将数据整理成如下格式:

1

2

3

4[

{"question": "What are the symptoms of diabetes?", "answer": "Symptoms of diabetes include increased thirst, frequent urination, and unexplained weight loss."},

{"question": "How is hypertension treated?", "answer": "Hypertension is typically treated with lifestyle changes and medications such as ACE inhibitors or beta-blockers."}

] - 数据清洗:去除噪声数据,确保问答对的质量。

2. 选择基础模型

- 选择一个适合的基础模型,例如:

- LLaMA(Meta 的开源模型)

- Falcon(TII 的开源模型)

- GPT-2/GPT-3(OpenAI 的模型)

- 这里以 LLaMA 为例。

3. 安装依赖

- 安装必要的 Python 库:

1

pip install transformers datasets accelerate peft

4. 加载基础模型和分词器

- 使用 Hugging Face 的

transformers库加载模型和分词器:1

2

3

4

5

6from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载 LLaMA 模型和分词器

model_name = "huggyllama/llama-7b" # 替换为你的模型路径

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

5. 准备训练数据

- 使用 Hugging Face 的

datasets库加载和预处理数据:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16from datasets import Dataset

# 假设数据已经整理成 JSON 格式

data = [

{"question": "What are the symptoms of diabetes?", "answer": "Symptoms of diabetes include increased thirst, frequent urination, and unexplained weight loss."},

{"question": "How is hypertension treated?", "answer": "Hypertension is typically treated with lifestyle changes and medications such as ACE inhibitors or beta-blockers."}

]

# 转换为 Hugging Face Dataset

dataset = Dataset.from_dict({"question": [d["question"] for d in data], "answer": [d["answer"] for d in data]})

# 分词

def tokenize_function(examples):

return tokenizer(examples["question"], examples["answer"], truncation=True, padding="max_length", max_length=512)

tokenized_dataset = dataset.map(tokenize_function, batched=True)

6. 微调模型

- 使用 Hugging Face 的

TrainerAPI 进行微调:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24from transformers import TrainingArguments, Trainer

# 训练参数

training_args = TrainingArguments(

output_dir="./results",

per_device_train_batch_size=4,

num_train_epochs=3,

logging_dir="./logs",

logging_steps=10,

save_steps=500,

save_total_limit=2,

learning_rate=5e-5,

fp16=True, # 使用混合精度训练

)

# 初始化 Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset,

)

# 开始训练

trainer.train()

7. 保存模型

- 训练完成后,保存微调后的模型:

1

2model.save_pretrained("./fine-tuned-llama")

tokenizer.save_pretrained("./fine-tuned-llama")

8. 测试模型

- 加载微调后的模型并进行测试:

1

2

3

4

5

6

7

8

9

10

11

12

13from transformers import pipeline

# 加载微调后的模型

model = AutoModelForCausalLM.from_pretrained("./fine-tuned-llama")

tokenizer = AutoTokenizer.from_pretrained("./fine-tuned-llama")

# 创建文本生成管道

generator = pipeline("text-generation", model=model, tokenizer=tokenizer)

# 测试

question = "What are the symptoms of diabetes?"

response = generator(question, max_length=100)

print(response)

关键点总结

- 数据准备:整理高质量的问答对数据。

- 模型选择:选择适合的基础模型(如 LLaMA、Falcon)。

- 微调训练:使用 Hugging Face 的

TrainerAPI 进行微调。 - 保存与测试:保存微调后的模型并测试其性能。

注意事项

- 计算资源:训练大模型需要强大的 GPU(如 A100、V100)。如果没有足够的资源,可以考虑使用云服务(如 AWS、Google Cloud)。

- 高效微调:如果资源有限,可以使用 LoRA(低秩适应)等技术进行高效微调。

- 数据隐私:如果数据涉及敏感信息,确保在训练和部署过程中遵守相关法规。

AnythingLLM不是用来训练大模型的

https://jycpp.github.io/24-08-21-AnythingLLM不是用来训练大模型的.html